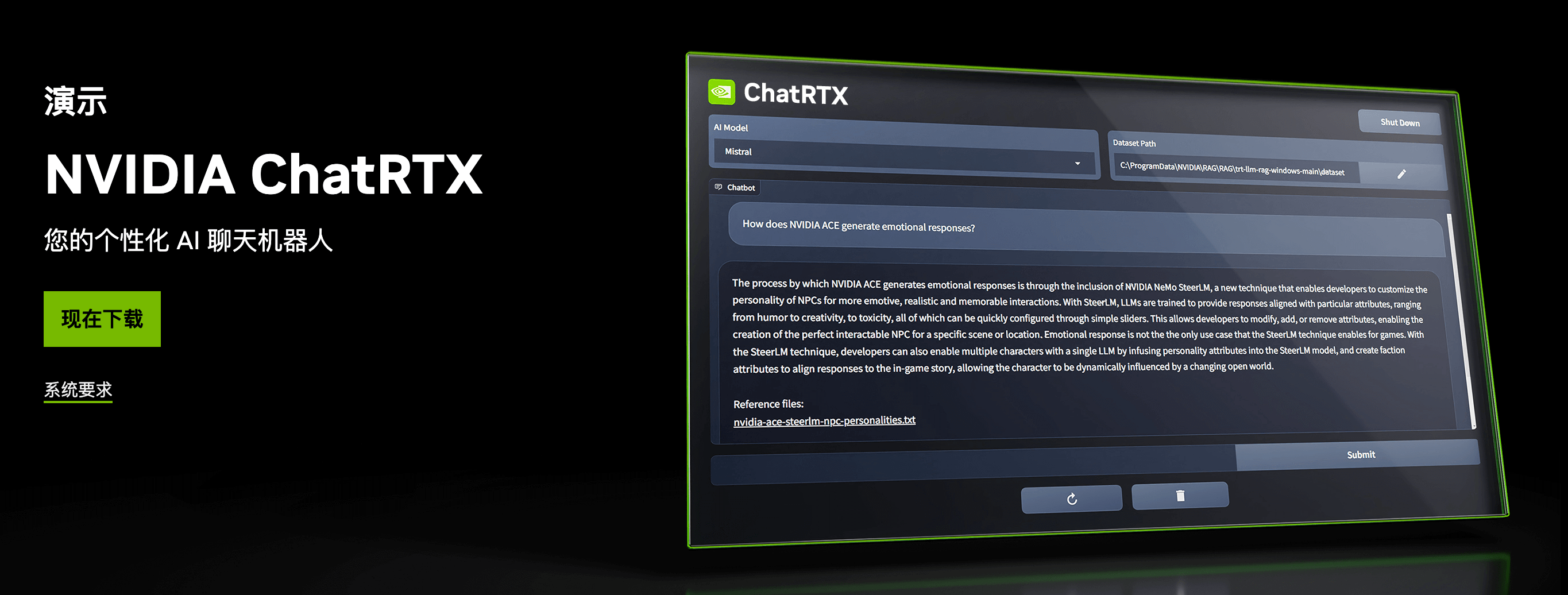

大型语言模型(LLM)如OpenAI的GPT-3展示了理解和生成类人文本的卓越能力。然而,随着对定制化和特定领域专业知识需求的增长,NVIDIA的ChatRTX应运而生,提供了一个利用NVIDIA强大RTX GPU性能的平台,让用户可以构建定制的LLM。本文将深入探讨ChatRTX的功能、优势以及它在各行业中的潜力。

ChatRTX的基础:NVIDIA RTX GPU

ChatRTX的核心是NVIDIA的RTX GPU。这些GPU以其在处理密集计算任务中的高性能和效率而闻名,对于训练大规模AI模型至关重要。RTX GPU支持复杂算法和大数据集,确保定制LLM能够精准快速地进行训练和微调。Ampere架构及其先进的Tensor Core进一步提升了AI模型的性能,使实时推理和训练更加高效。

ChatRTX的关键功能

定制化

ChatRTX的一大亮点是其定制LLM的能力。不同于通用模型,ChatRTX允许用户在特定数据集上微调模型,确保AI能够理解特定领域的细微差别。这种定制化对于医疗、金融和客户服务等行业尤为重要,因为领域特定知识可以显著提升交互和决策过程的质量。

可扩展性

ChatRTX的设计能够根据用户需求进行扩展。无论是小型初创企业还是大型企业,平台都能调整到不同层次的计算需求。这种可扩展性确保企业可以从小规模开始,随着需求增长逐步扩展AI能力,而无需担心计算基础设施的限制。

集成性

ChatRTX的另一个关键方面是其无缝集成能力。平台兼容多种AI和机器学习框架,使开发人员能够轻松地将定制LLM整合到现有工作流程中。这种灵活性对于希望增强AI能力但不愿全面改造当前系统的组织非常有利。

性能优化

NVIDIA的RTX GPU针对AI工作负载进行了优化,而ChatRTX充分利用了这种优化来提供高性能的结果。平台包括混合精度训练等特性,在保持精度的同时加速训练过程。此外,ChatRTX还利用了NVIDIA广泛的预训练模型和优化工具,为构建定制解决方案提供了坚实的基础。

使用ChatRTX的优势

提高效率

通过利用RTX GPU的高计算能力,ChatRTX显著减少了训练和部署LLM所需的时间。这种效率在时间至关重要的行业中具有竞争优势。

成本效益

从零开始开发定制LLM可能成本高昂。ChatRTX通过提供利用现有基础设施和模型的平台,减少了初始投资需求,提供了具有成本效益的替代方案。这种成本效益使先进的AI技术对更广泛的企业开放。

改善准确性

使用ChatRTX定制的LLM确保模型针对具体用例进行了调整,从而提高了输出的准确性和相关性。这种定制在自动化客户支持等应用中特别有益,因为理解上下文和意图对于提供令人满意的响应至关重要。

技术前瞻性

NVIDIA不断创新其GPU技术,确保像ChatRTX这样的平台始终处于AI开发的前沿。通过构建在ChatRTX上,企业可以使其AI战略具备前瞻性,保持在技术进步和市场趋势之前。

各行业的应用

医疗

在医疗领域,定制LLM可以显著改善患者护理和行政效率。ChatRTX可用于开发理解医学术语、协助诊断和提供个性化患者互动的模型。这种定制确保AI模型不仅准确,还能敏感地应对医疗专业人员和患者的特定需求。

金融

金融行业可以通过ChatRTX创建理解和分析复杂金融数据的模型。这些模型可以在欺诈检测、客户服务和金融规划中提供帮助,提供针对金融机构具体需求的见解。

客户服务

通过ChatRTX开发的定制LLM可以彻底改变客户服务,提供更准确和上下文相关的响应。这些模型可以处理广泛的客户查询,从基本信息到复杂问题解决,提升整体客户体验。

零售

在零售业,ChatRTX可以用于开发改进客户互动和库存管理的模型。定制LLM可以帮助理解客户偏好、提供个性化推荐和优化供应链流程。

数智朋克点评

NVIDIA的ChatRTX是一个强大的平台,旨在让定制大型语言模型的开发变得更加普及。通过利用RTX GPU的性能,ChatRTX提供了一个可扩展、高效和具有成本效益的解决方案,帮助企业充分利用AI的力量。无论是提升客户服务、改善医疗结果还是推动金融洞察,ChatRTX都提供了构建复杂AI模型所需的工具,适应特定行业需求。随着AI的不断发展,像ChatRTX这样的平台将在塑造技术和商业的未来中发挥关键作用。

粤公网安备44030002001270号

粤公网安备44030002001270号